La maturité IA des organisations - tour d'horizon critique

Mesurer la "maturité IA" : tour d'horizon critique

En 2025, rares sont les entreprises qui n'ont rien fait en IA. POC de computer vision en usine, chatbot RH, copilotes bureautiques, genAI dans le CRM ... L'IA est partout - sauf, souvent, là où elle produit une valeur durable.

Un peu comme appeler un plombier pour une fuite, et le trouver en train d'installer une LED connectée dans vos toilettes. C'est joli… mais le tuyau fuit toujours

Pour sortir du brouillard, les organisations se tournent vers des modèles de maturité IA : grilles à 4 ou 5 niveaux (Gartner, Accenture), cadres multidimensionnels (MITRE), modèles académiques ou sectoriels. Ils promettent tous la même chose : se situer, se comparer, piloter une trajectoire.

Cet article propose un tour d'horizon critique de ces échelles, avec trois objectifs :

- Montrer ce qu'elles mesurent réellement (et ce qu'elles ne mesurent pas).

- Discuter leurs limites méthodologiques et leurs usages politiques et business

- Expliquer pourquoi, dans la pratique, il faut souvent adapter ou combiner ces modèles plutôt que de les appliquer "en standard" - avec un exemple concret.

Pourquoi les modèles de maturité IA se sont imposés

Les études Accenture ou MIT CISR ont largement popularisé l'idée que la "maturité IA" est corrélée à la performance. Accenture identifie, par exemple, une petite minorité d'"AI Achievers" (≈12 % des entreprises étudiées) qui combinent un haut niveau de capacités IA et une croissance supérieure à leurs pairs. (Accenture)

De son côté, une étude MIT CISR sur 721 entreprises distingue quatre stades de maturité ("Experiment and prepare" → "AI future-ready") et montre que les organisations des deux derniers stades surperforment financièrement leur secteur. (MIT Sloan)

Ces travaux sont utiles pour deux raisons :

- Ils rappellent que la maturité IA est holistique : stratégie, données, technologie, organisation, culture, gouvernance et même business.

- Ils offrent un langage simple aux COMEX : "nous sommes plutôt stade 1–2, nous visons le stade 3–4".

Mais attention, les entreprises les plus performantes sont souvent celles qui, déjà avant l'IA, disposent :

- de plus de capital,

- de meilleurs talents,

- d'une culture de transformation plus avancée.

Elles ont donc plus de chances d'être "matures" en IA, indépendamment du modèle. Et beaucoup d'index intègrent déjà des KPI business dans la définition de la maturité… avant d'"observer" que la maturité est corrélée à la performance. La boucle est presque fermée.

Autrement dit : ces modèles racontent autant l'histoire de la maturité IA que celle de la maturité organisationnelle tout court.

... un peu de vocabulaire ...

- AI maturity (maturité IA) : degré d’intégration et de maîtrise de l’IA dans une entreprise (stratégie, organisation, culture, gouvernance, etc.). G2 ou Appinventiv parlent de 5 niveaux allant de l’idéation à la transformation.(learn.g2.com, Appinventiv)

- AI readiness (préparation) : capacité d’un pays, d’une administration ou d’un secteur à adopter l’IA (infrastructures, politiques publiques, compétences, régulation). C’est l’objet, par exemple, du Government AI Readiness Index d’Oxford Insights ou des outils de l’UNDP et de l’UNESCO.(Oxford Insights)

- Maturité d’un actif IA : niveau de robustesse et d’industrialisation d’un système IA donné (un moteur de recommandation, un chatbot, un modèle de scoring crédit, etc.). Cette notion est plus jeune, souvent déduite des frameworks organisationnels (MLOps, AI lifecycle, NIST AI RMF) plutôt que décrite dans un modèle unique.(NIST)

Ce que mesurent les échelles de maturité IA

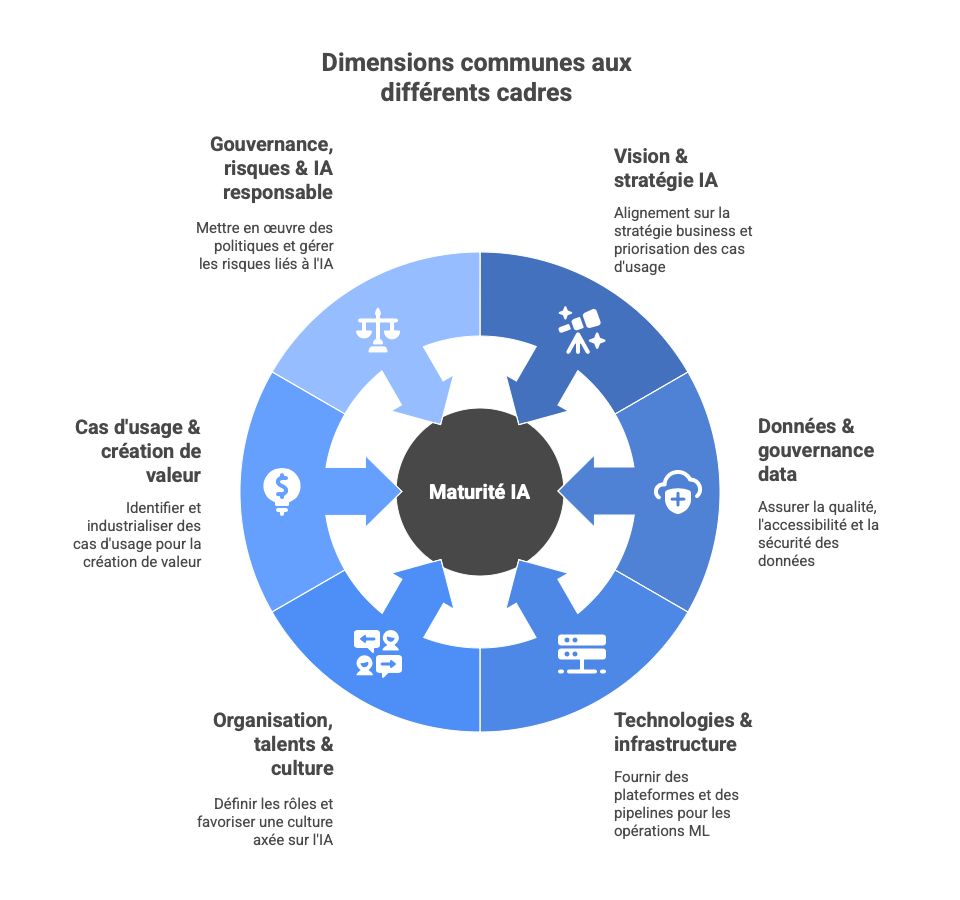

Malgré leurs différences, la plupart des cadres (Gartner, MITRE, MIT CISR, revues académiques) convergent sur 5–6 grandes dimensions. (MITRE)

-

Vision & stratégie IA : Alignement sur la stratégie business, clarté des priorités, arbitrage du portefeuille de cas d'usage.

-

Données & gouvernance data : Qualité, accessibilité, sécurité, conformité, capacité à alimenter des modèles (classiques et GenAI).

-

Technologies & infrastructure (MLOps / LLMOps) : Plateformes, pipelines, intégration SI, monitoring, sécurité des modèles.

-

Organisation, talents & culture : Rôles (CDAO, data scientists, ML engineers, product owners IA), operating model (centre d'excellence, équipes produits), acculturation des métiers.

-

Cas d'usage & création de valeur : Capacité à identifier, prioriser, industrialiser des use cases, et à en mesurer la valeur.

-

Gouvernance, risques & IA responsable : Politiques internes, conformité (EU AI Act, RGPD…), gestion des biais, supervision humaine.

Tour d'horizon rapide des grandes familles de modèles

Dans ce qui suit, on se focalise surtout sur :

- Les modèles de maturité d’entreprise (comment l’organisation gère son portefeuille d’actifs IA) ;

- Les indices d’adoption / readiness (pays, secteurs, santé…) ;

- Les implications pour la maturité d’un actif IA individuel (fiabilité, gouvernance, valeur).

Les grilles à 4–5 niveaux (Gartner, MIT CISR, Accenture)

-

Logique : on positionne l'entreprise sur un continuum (Ad hoc → Opportuniste → Systématique → Optimisé → Transformant).

-

Forces : pédagogiques, faciles à partager en COMEX, utiles pour des messages du type "nous sommes niveau 2, nous visons niveau 3–4".

-

Limites :

- vision linéaire et téléologique : tout le monde est supposé vouloir aller au "niveau 5",

- masquent l'hétérogénéité (une Business Unit peut être très avancée en data, très faible en gouvernance).

Les matrices multidimensionnelles (MITRE et dérivés)

-

Logique : scoring par dimension (stratégie, data, tech, talent, gouvernance…).

-

Forces : granulaire, utile pour cibler des plans d'action (ex. priorité 12 mois = renforcer la gouvernance et la culture).

-

Limites :

- plus lourds,

- risquent de produire des scores sophistiqués mais peu reliés aux décisions si la démarche n'est pas pilotée.

Les modèles de « readiness » (préparation)

Des travaux récents distinguent la maturité "d'usage" et la readiness : la capacité à exploiter l'IA sans forcément l'avoir déjà déployée massivement. On la retrouve dans les indices de readiness nationaux, mais aussi dans des évaluations d'entreprises autour de la sécurité, de la gouvernance ou de la préparation aux risques. (TechRadar)

- Forces : très utiles pour les organisations au démarrage, qui doivent sécuriser les fondamentaux (data, sécurité, gouvernance).

- Limites : peuvent encourager une préparation sans fin si on ne fixe jamais le moment où l'on doit passer à l'action.

Les modèles d'IA responsable

Certains cadres se concentrent sur la seule dimension "IA de confiance" : explicabilité, équité, sécurité, documentation, conformité (MITRE, NIST, modèles académiques de "Responsible AI Maturity"). (MITRE)

- Forces : indispensables dans les secteurs régulés, précieux avec l'arrivée de l'AI Act.

- Limites : pris isolément, ils peuvent être perçus comme une couche "compliance" déconnectée de la stratégie et des produits.

Comment on mesure vraiment : acteurs, granularité, qualité

C'est ici que se joue la différence entre un modèle utile et un jouet PowerPoint.

Qui répond au questionnaire ?

Un même modèle peut donner des résultats très différents selon qui répond :

- DSI seule : sur-évaluation des aspects tech, sous-estimation des freins métiers.

- COMEX seul : vision très optimiste, peu de granularité opérationnelle.

- Métiers seuls : focalisation sur les cas d'usage visibles, oubli des infrastructures et de la gouvernance.

Les retours d'expérience montrent que les démarches les plus robustes combinent :

- une auto-évaluation multi-acteurs (DSI, métiers, data, risque/compliance, RH),

- et, idéalement, une revue critique externe (audit interne, partenaire, pair review) pour limiter les biais.

À quel niveau mesure-t-on ?

Mesurer "la maturité IA de l'entreprise" comme un score unique est souvent trompeur. Les organisations avancées :

- segmentent par BU / géographie / fonction (ex. production, finance, marketing),

- cartographient des profils de maturité plutôt qu'un chiffre global.

Exemple typique : un groupe industriel où la finance est très avancée en IA (contrôle de gestion, fraude), alors que les sites de production restent au stade POC.

Fiabilité & validité : les grands absents des démarches "express"

On parle rarement de :

- Fiabilité : si on refait l'évaluation 6 mois plus tard, avec le même panel, retrouve-t-on un score comparable à contexte stable ?

- Validité : est-ce que le score mesure vraiment ce qu'il prétend mesurer (capacité IA), ou plutôt le niveau de communication, le budget IT, etc. ?

C'est pourtant là que commence le maturity theatre : questionnaires mal conçus, réponses complaisantes, scores interprétés comme des "notes" alors qu'ils sont des signaux partiels.

Le maturity theatre, c’est quand ton questionnaire mesure surtout ton optimisme — et encore, seulement les jours où le budget IT n’est pas en RTT.

Une littérature de revue récente insiste d'ailleurs sur ces limites : beaucoup de modèles sont construits sans validation empirique solide et ressemblent plus à des artefacts marketing qu'à des instruments de mesure au sens strict. (ResearchGate)

Un exemple concret : combiner et adapter les échelles dans une ETI industrielle

Prenons un cas : une ETI industrielle de 2 500 personnes, présente dans plusieurs pays, avec :

- un historique fort en automatisation industrielle,

- un SI fragmenté,

- quelques POC IA (maintenance prédictive, vision sur chaîne) restés en pilote.

Avant : la "maturité IA" subie

Au départ, l'ETI :

- remplit un questionnaire type Gartner avec son intégrateur : score global "niveau 2/5", commentaires génériques ;

- a un MITRE-like fourni par un second prestataire, avec 20 dimensions scorées, sans lien direct avec ses priorités ;

- se revendique "en bonne voie vers la data-driven factory" dans sa communication.

Résultat : beaucoup de slides, peu de décisions nouvelles.

... bref ... à force d’empiler les diagnostics façon Gartner, MITRE et slogans “data-driven”, on fini par atteindre un excellent niveau… de maîtrise du format 16:9. La seule chose vraiment industrialisée pour l’instant, c’est la production de slides

Adaptation pragmatique : un modèle hybride

Un groupe de travail interne (DSI, directeur industriel, responsable data, finance, RH) décide de repartir du besoin :

"De quelles informations avons-nous besoin pour arbitrer nos investissements IA sur 3 ans ?"

Ils construisent un modèle simplifié, en combinant :

- la grille 4 niveaux de type MIT CISR pour garder un discours compréhensible pour le COMEX ;

- un sous-ensemble de 8 dimensions inspirées de MITRE (stratégie, data industrielle, plateforme, MLOps, cas d'usage, talents, gouvernance, IA responsable).

Les choix d'adaptation :

-

Réduction : de 20 à 8 dimensions, en fusionnant ou supprimant celles jugées redondantes ou peu pertinentes à 3 ans.

-

Re-pondération :

- poids renforcé sur data industrielle et plateforme IIoT/IA (points douloureux identifiés),

- poids moindre sur des sujets très longs terme (par ex. IA embarquée sur tous les équipements).

-

Granularité ciblée : deux profils de maturité distincts :

- un pour les usines européennes,

- un pour les filiales commerciales.

Après : ce que ça change réellement

Les résultats (discutés en ateliers, pas juste en ligne) montrent :

- des usines très avancées en automatisation mais très faibles en gouvernance data (capteurs hétérogènes, historisation incomplète) ;

- des filiales commerciales plus matures en usage de la genAI bureautique (vente, marketing), mais sans gouvernance ni formation structurée.

Concrètement, le COMEX prend trois décisions :

- Investissement prioritaire dans un socle data industriel commun (data historians, standardisation capteurs) plutôt que dans un nouveau POC computer vision.

- Création d'un centre de compétence IA industrielle rattaché à la direction industrielle (et non à la DSI seule), chargé de standardiser méthodes et stacks.

- Lancement d'un programme de formation IA/GenAI pour les équipes commerciales, couplé à des guidelines d'usage responsable.

La même démarche de maturité, mais adaptée et combinaison intelligente de deux modèles, a donc :

- arbitré des budgets,

- modifié l'organisation,

- structuré des priorités produits/process.

C'est typiquement le niveau d'ancrage auquel un COMEX commence à y voir une démarche stratégique, pas seulement un "framework de consultant".

Méthode minimaliste pour adapter / combiner une échelle à son contexte

Sans prétendre fournir une méthode complète, on peut proposer un petit protocole en 4 étapes :

-

Clarifier l'usage

- Question simple : "Quelles décisions voulons-nous éclairer dans les 12–24 mois (budget, orga, produits, make-or-buy…) ?"

- C'est cette question qui doit guider le choix ou l'adaptation du modèle.

-

Choisir un "backbone"

-

Réduire & re-pondérer

- Limiter à 6–10 dimensions maximum (au-delà, personne ne pilote vraiment).

- Augmenter le poids des dimensions qui font vraiment la différence dans votre secteur (gouvernance dans la banque, data industrielle dans la manufacturing, etc.).

- Documenter ce choix (pourquoi cette pondération ?) : c'est une décision stratégique, pas un détail technique.

-

Décider des règles du jeu de la mesure

- Panel de répondants (pluri-acteurs, pas uniquement la DSI).

- Granularité (global + BU clés / pays / fonctions).

- Fréquence (tous les 12–18 mois, pas tous les mois).

- Lien explicite avec les décisions (chaque écart majeur doit être rattaché à un plan d'action).

Ce type d'approche, même très allégée, évite déjà 80 % du maturity theatre.

TPE/PME : un modèle natif, pas une grande grille allégée

Pour les TPE/PME, la plupart des modèles "grand compte" sont tout simplement disproportionnés :

- pas d'équipe data dédiée,

- dépendance aux éditeurs SaaS (ERP, CRM, compta, RH) qui embarquent eux-mêmes de l'IA,

- contraintes fortes de cash et de temps.

Dans un tel contexte, un modèle de maturité IA raisonnable se ramène souvent à 4 questions :

-

Usage

- Dans quels outils la PME utilise-t-elle déjà de l'IA (copilotes bureautiques, CRM, outil de support, comptabilité) ?

- Ces usages sont-ils compris et appropriés (ou subis) ?

-

Données métiers clés

- Les données structurantes (clients, produits, stocks, interventions) sont-elles relativement propres et accessibles ?

- Y a-t-il des exports/API simples pour alimenter un projet IA ciblé (ex. prévision de demande) ?

-

Partenaires & lock-in

- Sur quels éditeurs / intégrateurs la PME s'appuie-t-elle ?

- Quels sont les risques de dépendance (contrats, portabilité des données, coûts de sortie) ?

-

Capacité de pilotage

- Qui, dans la PME, est capable de challenger un discours vendeur sur l'IA (RSSI, DAF, dirigeant, consultant de confiance) ?

- Existe-t-il un minimum de gouvernance (charte d'usage, gestion des risques de confidentialité, etc.) ?

Pour une PME, parler de "niveau 3 vs niveau 4 MITRE" n'a souvent pas de sens : la question pertinente est plutôt :

"Avec nos ressources et notre dépendance aux SaaS, quels 2–3 usages IA peuvent vraiment changer la donne à 18 mois, sans nous enfermer dans un verrou technologique ?"

Au-delà de l'entreprise : écosystèmes, chaîne de valeur et clients

Les modèles de maturité IA sont massivement entreprise-centrés. Mais, pour un stratège, la vraie question est souvent :

"Notre maturité IA nous donne-t-elle un avantage dans une chaîne de valeur donnée ?"

Trois angles sont souvent absents des modèles standards :

-

Maturité des partenaires

- Intégrateurs, éditeurs, hyperscalers, bureaux d'études… Une entreprise peut se déclarer mature alors que son écosystème est en retard, ce qui bloquera mécaniquement la mise à l'échelle.

- Inversement, beaucoup de PME s'appuient justement sur la maturité IA de leurs fournisseurs SaaS.

-

Maturité du marché et des clients

- Acceptation de l'IA (trust, consentement, culture),

- volonté ou non de payer un surcoût pour des services "augmentés par l'IA",

- attentes en matière de transparence, d'éthique, de localisation des données.

-

Rôle des régulateurs et standards de filière

- AI Act, référentiels sectoriels, standards open source, écosystèmes régionaux (clusters, pôles de compétitivité).

- Dans certains secteurs, la capacité à se conformer rapidement à des standards ou audits IA devient un élément central de la maturité.

Une approche plus réaliste consiste à compléter la "maturité interne" par un diagnostic de maturité d'écosystème : où en sont mes partenaires, mes clients, mes régulateurs ? À défaut de modèle clé en main, cela peut prendre la forme d'un simple heatmap qualitatif.

Relier la maturité IA à des enjeux business concrets

Les modèles de maturité IA parlent de stratégie, de data, de technologies ou de gouvernance. Mais pour un COMEX, la question centrale reste beaucoup plus directe :

“En quoi notre niveau de maturité IA modifie-t-il nos décisions business, nos coûts et nos opportunités de croissance ?”

Cet angle est souvent absent des modèles standards, pourtant la maturité IA influence non seulement la performance opérationnelle, mais aussi la réallocation de capital, la capacité de différenciation, et même la licence to operate dans certains secteurs.

Accenture observe par exemple que les “AI Achievers”, c’est-à-dire les entreprises ayant atteint une maturité IA élevée, présentent une croissance nettement supérieure à leurs pairs (≈50 % d’écart de performance financière cumulée), en raison d’une meilleure capacité à investir dans des cas d’usage alignés sur la valeur et à repenser leurs offres. (Accenture)

De son côté, le MIT CISR montre que les entreprises situées dans les deux stades les plus avancés (“Integrated” et “AI future-ready”) obtiennent des résultats financiers supérieurs grâce à une articulation explicite entre capacités IA, transformation des processus et innovation business. (MIT Sloan)

On peut regrouper ces impacts business en trois catégories :

1. Allocation de capital & arbitrage du portefeuille d’initiatives

Une évaluation de maturité bien construite permet de décider où investir et où ne pas investir :

- Dans une organisation “niveau 1–2”, le ROI des projets IA dépend surtout des prérequis structurels (data qualité, unification SI) : les investissements “phare” sont souvent prématurés.

- À partir du “niveau 3–4”, les modèles de maturité montrent une corrélation forte entre industrialisation des capacités IA et efficacité de déploiement multi-BU, ce qui justifie des investissements plus lourds et plus concentrés.

- Plusieurs études soulignent que les entreprises matures réallouent le capital plus rapidement dès qu’un cas d’usage ne délivre pas. (MIT Sloan)

En pratique, la maturité IA permet de transformer le portefeuille IA d’une liste de POC en une logique de capital intensif structuré.

2. Différenciation & nouveaux modèles économiques

Plus une organisation est mature, plus elle est capable de transformer l’IA en avantage business :

- Nouveaux services “augmentés” (maintenance prédictive contractualisée, services financiers personnalisés, automatisation assistée)

- Pricing dynamique ou optimisation de marge (retail, transport, industrie)

- Personnalisation de masse dans le e-commerce ou les services

- Réduction du churn, meilleure activation client, segmentation prédictive

- Accélération du time-to-market par automatisation de la R&D ou du développement logiciel

Les entreprises identifiées comme "AI Achievers" par Accenture déclarent que 65 % de leur croissance incrémentale provient directement de produits/services augmentés par l’IA. (Accenture)

Autrement dit : la maturité IA n’est pas qu’un score organisationnel — c’est la capacité à monétiser l’IA.

3. Risques, conformité et “licence to operate”

Avec l’arrivée de l’AI Act et la montée des exigences clients, la maturité IA responsable devient un enjeu économique :

- Les modèles MITRE et NIST soulignent que la maturité en IA responsable conditionne la capacité à démontrer la traçabilité, l’explicabilité et la gestion des risques algorithmique. (MITRE)

- Dans certains secteurs (banque, santé, industrie à risque), accéder à certains marchés ou appels d’offres n

Faut-il vraiment viser le "niveau maximum" ? Critique de la métaphore de la maturité

Parler de "maturité" suggère une trajectoire linéaire : on part du niveau 1, on progresse vers le niveau 5, qui serait la forme "adulte" idéale. Cette métaphore porte plusieurs biais :

- Téléologie implicite : tout le monde serait censé vouloir devenir "AI future-ready" au sens des grands cabinets, quelle que soit sa taille, sa stratégie, son secteur.

- Uniformisation : une banque systémique régulée et une PME agroalimentaire seraient jugées à l'aune du même idéal.

Or, du point de vue de la stratégie et de l'innovation, on est souvent plus proche de la logique de capacités dynamiques :

Ce qui compte n'est pas tant d'atteindre un "niveau 4" figé que de développer la capacité à réapprendre, reconfigurer et réallouer rapidement ses ressources IA quand le contexte change.

Cela se traduit par :

- des portefeuilles d'initiatives IA, avec arrêt/renforcement régulier (optionnalité), plutôt qu'une volonté d'industrialiser tout, tout de suite ;

- des "plateformes d'apprentissage" (données, outils, culture) capables d'absorber des ruptures technologiques (agents, modèles open weights, edge AI…) sans tout refaire.

Dans cette perspective, la maturité IA est moins un score statique qu'un rythme de réinvention.

Ne pas siloïser : articuler maturité IA, data, digital, agile…

Dernier angle mort fréquent : on accumule les frameworks spécialisés :

- maturité digitale,

- maturité data,

- maturité agile,

- maturité innovation,

- maturité IA,

- maturité IA responsable…

Chaque modèle vient avec ses questionnaires, ses scores, ses slides, souvent sans articulation.

Pour un stratège, l'enjeu est plutôt de disposer d'une vue unique des capacités de l'entreprise, dont l'IA n'est qu'un morceau. Des travaux récents sur les digital maturity models montrent d'ailleurs que l'IA devient progressivement une dimension intégrée de la maturité digitale globale plutôt qu'un silo à part. (Society)

Une façon pragmatique de faire :

- utiliser un référentiel unique de capacités (ex. 20–30 capacités business/tech),

- faire apparaître l'IA comme un amplificateur de certaines (marketing, opérations, R&D, compliance) plutôt qu'un bloc séparé,

- aligner les diagnostics de maturité (data, IA, digital) sur ce référentiel commun.

Modèle de maturité : instrument de mesure… et instrument de pouvoir

Enfin, toute démarche de maturité est aussi un acte politique :

-

Qui porte le modèle ? DSI, direction data, innovation, risque, COMEX ?

-

Qui gagne ou perd du pouvoir quand un diagnostic met en lumière que :

- la DSI est en retard sur la data platform,

- les métiers multiplient les POC non industrialisables,

- la compliance n'a aucun levier sur les projets GenAI ?

Les tensions fréquentes :

-

DSI vs métiers :

- la DSI veut standardiser, sécuriser, rationaliser ;

- les métiers veulent expérimenter rapidement, parfois hors des radars.

-

Data vs fonctions historiques :

- création d'un CDAO ou d'un centre d'excellence IA perçu comme un "État dans l'État".

-

Compliance / juridique vs innovation :

- l'IA responsable peut être vécue soit comme une contrainte, soit comme un avantage compétitif (capacité à passer la régulation avant les autres).

Un modèle de maturité devient utile quand :

- il est co-construit (au moins dans ses déclinaisons pratiques),

- il est explicite sur ses implications (qui décide quoi si on est "faible" sur telle dimension),

- il sert de base à des négociations assumées (priorités, budgets, trajectoires), pas seulement à des slides de communication.

2025–2030 : à quoi devrait ressembler un modèle de maturité IA robuste ?

Dans un paysage technologique et réglementaire très mouvant (GenAI, agents, AI Act, modèles open weights, sécurité spécifique IA…), les modèles de maturité robustes devraient suivre quelques principes de design :

-

Simplicité ciblée

- Peu de niveaux, peu de dimensions, mais bien choisies.

- Suffisamment simples pour être ré-expliquées en 5 minutes à un COMEX.

-

Révision régulière

- Revue du modèle tous les 18–24 mois : dimensions, poids, questions.

- Capacité à intégrer de nouvelles réalités (agents, edge AI, nouvelles régulations) sans tout repartir de zéro.

-

Ancrage décisionnel

- Chaque écart de maturité significatif doit être rattaché à une décision potentielle : investir, désinvestir, réorganiser, former, changer de partenaire.

- Pas de diagnostic sans plan d'action.

-

Articulation écosystème / entreprise

- Compléter la mesure interne par une lecture de la maturité des partenaires, des clients, des régulateurs.

- Intégrer ces éléments dans les arbitrages (choix de filières, géographies, fournisseurs).

-

Transparence sur les limites

- Être explicite sur les biais possibles : sélection des répondants, biais de taille/secteur, intégration partielle de KPI business dans la définition de la maturité.

- Utiliser les résultats comme hypothèses de travail, pas comme vérité absolue.

En guise de conclusion : utiliser les échelles, ne pas les subir

Les modèles de maturité IA ne sont ni des gadgets, ni des oracles. Bien utilisés, adaptés et combinés :

- ils permettent de mettre de l'ordre dans le chaos des initiatives IA,

- d'aligner les acteurs (techniques, métiers, dirigeants, compliance),

- d'éclairer des décisions très concrètes (budget, organisation, produits, partenariats).

Mal utilisés, ils alimentent le maturity theatre : de beaux scores, peu de valeur, beaucoup de slides.

La clé, pour un stratège ou un COMEX, n'est donc pas de choisir "le meilleur modèle" mais de se poser trois questions très simples :

- Pour quelles décisions avons-nous besoin de mesurer notre maturité IA ?

- Quel modèle minimal, combiné et adapté, nous donnera des signaux réellement actionnables ?

- Sommes-nous prêts à traiter cette mesure comme un outil de transformation – y compris dans ses implications politiques – plutôt que comme un exercice de communication ?

C'est à cette condition que les échelles de maturité IA deviennent autre chose qu'une littérature de cabinet : un instrument de pilotage lucide, adapté à la réalité de l'entreprise et de son écosystème.

Forces et faiblesses des grandes stratégies de mesure

Ce que les cadres font bien

-

Donner un langage commun : Les 4–5 niveaux récurrents (exploration → expérimentation → opérationnel → systémique → transformationnel) permettent aux dirigeants, DSI, CDO, métiers et régulateurs de parler de la même chose.

-

Éclairer les angles morts : MITRE et OWASP, par exemple, rendent visible tout ce qui relève de l’éthique, de la sécurité, de la gestion des risques, qui a longtemps été sous-pondéré.

-

Servir de socle pour une feuille de route : AWS ou Appinventiv fournissent des recommandations par niveau : quelles capacités renforcer pour « monter » d’un cran (plateforme de données, MLOps, formation, gouvernance…).

-

Relier maturité et performance : MIT Sloan, LXT et certains indices (IBM, NASSCOM) montrent empiriquement que les organisations plus matures en IA ont tendance à surperformer sur la croissance et la productivité.

Les limites et biais récurrents

-

Maturité " checkbox " vs maturité réelle : beaucoup de modèles peuvent être remplis à base de questionnaires internes, donnant une image flatteuse sans refléter :

- la qualité réelle des données ;

- la robustesse des déploiements ;

- la valeur business effectivement créée.

C’est ce que soulignent les travaux sur l’efficacité de l’adoption IA : un score élevé de readiness ne garantit pas un ROI mesurable.

-

Fragmentation des modèles : chaque cabinet propose « son » framework ; des acteurs comme Appinventiv expliquent même que le sur-mesure est indispensable; il est difficile pour un dirigeant de comparer les scores entre les frameworks.

-

Sous-estimation de la complexité de l’IA générative et agentique : Les rapports Deloitte et Gartner montrent que les projets GenAI / agentic sont adoptés très vite… mais que beaucoup échouent à passer à l’échelle ou sont annulé. Or beaucoup de modèles de maturité n’avaient pas initialement été pensés pour ces nouveaux paradigmes (agents autonomes multi-étapes, orchestration complexe, chaînes d’outils).

-

Écart entre pays / secteurs : Il y a des écarts très importants entre les pays en matière de readiness IA – et encore plus lorsqu’on intègre la dimension responsable / éthique.

Annexe - Les grands modèles

Le modèle de Gartner : 5 niveaux, 7 piliers

Référence Gartner propose un modèle à 5 niveaux de maturité IA, très largement repris et popularisé.(LinkedIn,AImaturityToolKit)

Les niveaux sont souvent décrits comme :

- Awareness : L’IA est perçue comme tendance. Quelques expérimentations isolées, pas de stratégie ni de budget structuré.

- Active : POC et pilotes dans quelques équipes, sponsor local (DSI, marketing…). Peu de gouvernance, forte dépendance à des consultants.

- Operational : Des cas d’usage en production dans certains processus, ROI mesurable, émergence de pratiques MLOps.

- Systemic : L’IA irrigue la majorité des workflows, les programmes sont transverses, l’organisation s’appuie sur des plateformes partagées.

- Transformational : L’IA fait partie de l’ADN de l’entreprise, elle permet de nouveaux modèles économiques, produits et services.

Gartner évalue la maturité sur 7 piliers (stratégie, produit, gouvernance, ingénierie, données, operating model, culture), et fournit un toolkit de diagnostic et de feuille de route pour les CIO/CDO.(LinkedIn)

Forces

- Langage simple, 5 niveaux facilement compréhensibles par les dirigeants ;

- Couplé à des benchmarks sectoriels (via les études LXT, etc.) qui permettent de se comparer à ses pairs ;(lxt.ai)

- Directement orienté vers la valeur business et l’industrialisation.

Limites

- Méthodologie détaillée accessible seulement aux clients Gartner ;

- Éthique, impact sociétal et régulation AI Act peu détaillés dans le modèle de base (souvent traités dans d’autres rapports) ;

- Le scoring reste largement déclaratif (auto-positionnement des dirigeants).

Le MITRE AI Maturity Model (AIMM) : 6 piliers, 20 dimensions

Référence MITRE, organisme à but non lucratif très influent sur les questions de sécurité et de gouvernance, a publié un AI Maturity Model (AIMM) et un outil d’auto-évaluation.(aimaturitymodel.mitre.org)

Le modèle repose sur 6 piliers :

- Ethical, Equitable and Responsible Use

- Strategy & Resources

- Organization

- Technology Enablers

- Data

- Performance & Application

Chaque pilier est décliné en environ 20 dimensions (ex. politique de transparence, gestion des biais, capacité de monitoring, intégration SI, etc.) évaluées sur 5 niveaux : Initial → Developing → Defined → Managed → Optimizing.

Exemple de lecture pour un actif IA donné (par ex. un moteur de scoring crédit) :

- Niveau Initial (Data) : données non cataloguées, qualité non mesurée, traçabilité limitée ;

- Niveau Managed : gouvernance data formalisée, contrôles qualité automatisés, traçabilité de bout en bout avec journaux d’accès et d’usage.

Forces

- Met l’éthique et la responsabilité en premier pilier, ce qui est inédit par rapport à d’anciens modèles plus technico-centrés ;

- Très détaillé : utile pour construire un plan de transformation pluri-annuel ou pour structurer une démarche de conformité aux normes (AI Act, ISO 42001, NIST AI RMF).(NIST)

- Gratuit, documenté, accompagné d’un guide.

Limites

- Complexité et densité : un petit ou moyen acteur peut le trouver « overkill » ;

- Moins centré sur le portefeuille de cas d’usage que sur les capacités organisationnelles globales.

l’AIMM mesure la maturité d’une IA… mais si ton modèle répond encore "42" à toutes les questions, c’est qu’il est probablement resté bloqué en niveau Initial ... au moins, il a déjà lu Hitchhiker’s Guide to the Galaxy.

Le modèle MIT CISR / MIT Sloan : 4 stades de l’« enterprise AI »

Le MIT Center for Information Systems Research (MIT CISR) a étudié plus de 700 entreprises pour relier maturité IA et performance financière.(Threads)

Leur modèle décrit 4 stades typiques :

- Experimentation / Silos – POC dispersés, budgets locaux, pas de gouvernance centrale.

- Function-led – Quelques fonctions (marketing, ops) structurent des programmes IA plus larges, souvent autour de l’analyse de données.

- Enterprise – L’IA est pilotée au niveau groupe, avec data platform, gouvernance, équipes transverses.

- AI future-ready – L’entreprise combine des systèmes IA avancés, des processus agiles et une culture d’apprentissage continu.

L’article « What’s your company’s AI maturity level? » traduit ce modèle en questions concrètes pour les conseils d’administration et comités exécutifs.(Threads)

Forces

- Lien explicite entre maturité et création de valeur financière ;

- Très utilisable en comex : peu de niveaux, visuel simple, langage non technique.

Limites

- Moins prescriptif que MITRE ou Gartner : c’est davantage une grille de lecture qu’un outil méthodologique détaillé ;

- Peu de guidance opérationnelle sur la mise en œuvre MLOps, la supervision, etc.

Deloitte et les frameworks orientés IA générative

Deloitte ne publie pas un modèle unique de maturité IA, mais une série de cadres et d’enquêtes autour de la State of Generative AI in the Enterprise.(Deloitte Brazil)

Les rapports 2024–2025 soulignent :

- une explosion des pilotes GenAI dans toutes les industries ;

- un décalage entre l’enthousiasme initial et la capacité réelle à passer à l’échelle ;

- l’importance des questions de TRiSM (Trust, Risk, Security Management), en lien avec les cadres NIST, ISO, etc.(NIST)

Dans la pratique, les approches Deloitte reprennent souvent des phases de maturité (proches de Foundational → Experimental → Operational → Transformational), appliquées spécifiquement :

- à l’IA générative (chatbots, assistants, copilots) ;

- aux agents IA (agentic AI), en lien avec les prévisions Gartner sur le fort taux d’échec de ces initiatives (plus de 40 % de projets agentiques devraient être abandonnés d’ici 2027).(Reuters)

Forces

- Forte connexion avec les problématiques de risque, conformité et gouvernance ;

- Vision fine des différences sectorielles (banque, assurance, santé, industrie, services professionnels).

Limites

- Modèle moins standardisé que Gartner / MITRE : il varie selon les offres et industries ;

- Documentation détaillée souvent réservée aux clients / prospects.

AWS Generative AI Maturity Model : 4 niveaux pour la GenAI

AWS propose un maturity model pour l’adoption de l’IA générative, avec une documentation très concrète.(AWS Documentation)

Les 4 niveaux :

- Envision : Compréhension des concepts GenAI, identification de premiers cas d’usage, cadrage des risques.

- Experiment : POC structurés, mise en place des premières briques techniques, appropriation par les équipes métier.

- Launch : Déploiement de solutions en production avec gouvernance, suivi de performance, gestion de la sécurité.

- Scale : Réutilisation de composants, plateformes partagées, industrialisation à l’échelle de l’entreprise.

Le modèle couvre à la fois :

- les niveaux (où en est l’organisation) ;

- et les aspects (stratégie, data, sécurité, opérations, etc.), avec des recommandations associées à chaque niveau.

Forces

- Très utile pour structurer la montée en puissance de projets GenAI ;

- Directement couplé aux services AWS (Bedrock, Guardrails, monitoring…).

Limites

- Centré sur GenAI : ne couvre pas toujours les usages « classiques » (prédiction, optimisation) ;

- Fortement lié à l’écosystème AWS, moins neutre qu’un MITRE ou un cadre académique.

OWASP AIMA : maturité IA orientée sécurité et usage responsable

L’OWASP (Open Worldwide Application Security Project) a lancé le projet AI Maturity Assessment (AIMA), en s’inspirant du modèle SAMM utilisé pour la sécurité des logiciels.(GitHub)

Objectifs :

- fournir un cadre de maturité pour la sécurité et l’usage responsable des systèmes IA ;

- rester agnostique des technologies (pas limité à un cloud ou une stack).

Le projet prévoit :

- des domaines (stratégie, conception, implémentation, opérations, gouvernance) ;

- des pratiques business avec plusieurs niveaux de maturité (3 niveaux par pratique) ;

- un focus particulier sur la sécurité des modèles, la confidentialité, la robustesse face aux attaques (ex. prompt injection, exfiltration de données).

Forces

- Comble un vide : beaucoup de modèles parlent peu de sécurité détaillée ;

- Aligné avec la culture OWASP, donc facilement intégrable dans les pratiques de sécurité existantes.

Limites

- Projet encore jeune : la documentation est moins stabilisée que pour OWASP SAMM ;

- Plutôt orienté équipe sécurité / risk qu’instances de gouvernance business.

Modèles francophones : Yes We Prompt, Videns, Prodware…

Plusieurs acteurs francophones ont développé des modèles adaptés aux PME / ETI :

-

Yes We Prompt – Indice de maturité IA

- Outil d’auto-évaluation gratuit, avec 4 niveaux (de l’« IA gadget » à l’IA concurrentielle).

- L’édition 2024 montre que beaucoup de PME françaises restent dans des usages opportunistes et non cadrés.(Yes We Prompt)

-

Videns – Lucia

- Évalue la maturité IA sur 5 axes : données, outils & technologies, méthodes, talents, organisation.

- Propose 3 niveaux de maturité par axe, issus d’entretiens et de questionnaires, pour aboutir à un diagnostic global.(Appinventiv)